AIとスパコンで医療はどう変わるのか?

AIとスパコンで医療はどう変わるのか?

NU7(National University Seven)2022.7No.42から転載

名古屋大学情報連携推進本部副本部長

森健策

自己紹介

私は学部4年生の頃から約30年にわたって医療分野における画像処理の研究をしてきました。

1990年代、CT画像が急速に高画質化し、3次元画像が容易に撮れるようになりました。そこで私は、臓器内部を自由自在に観察できる仮想的な内視鏡の開発に挑戦しました。これが私のキャリアの始まりです。

私の開発した仮想化内視鏡(後述)を使うと、患者の体内を実際に内視鏡で観察しているような3次元画像が得られます。仮想世界なので、横隔膜を突き破って胃の中に入っていくことも可能です。

私の研究室では、CT画像によって臓器を正確に認識して手術や検査を支援する機器、VRによって人体解剖構造を示して学習者に役立てる機器、画像解析と3Dプリンターによって臓器モデルを造形する機器、自動診断するAI内視鏡(後述)などを開発してきました。

AI診断装置(CAD)とは

AIと言うと、多くの人は「人の知的な活動を模したもの」を思い浮かべますが、現状、「機械学習により、画像等のパターン情報を認識理解するもの」が多く、AI診断装置も画像診断が中心です。

AI診断装置は医療機器なので、薬機法の承認が必要です。そのため、まだそれほど多くはありません。

いくつか紹介すると、AI内視鏡「エンドブレイン」(後述)は名古屋大学が開発し、国内で初めて承認されたAI医療機器です。

胸部X線像からCOVID-19を診断するAI (後述)や、脳動脈瘤を診断するAIもあります。これらは日本のエヌピクセル社と言うベンチャーが開発しました。糖尿病網膜症を画像診断するAIもあります。

こうしたAI医療機器を「CAD」(コンピューターAided Diagnosis)と言います。「CADe

」(Computer Aided Detection)」は画像から病変部位を自動検出します。「CADx」はCADより高度な診断をします。「CAD+」(トリアージ型CAD)は撮影直後の画像を分析し、緊急性の有無を医師に提示・警告します。

AIの診断は通常は参考程度で、最終的な診断は医師が下しますが、心電図のように、AIの自動診断に完全に任せる場合もあります。

AI内視鏡「エンドブレイン」

内視鏡分野におけるAI医療機器は、画像から異常部位を検出し、悪性度を診断し、治療計画の決定を支援します。

さらに手術中、腹腔鏡写し出す映像と術前に撮影したCT画像から、脂肪に覆われた臓器の構造や周辺の血管の位置を認識することで、手術の支援をします。

2019年3月、大腸がん等を早期発見するAI内視鏡「エンドブレイン」が発売されました。発売元はオリンパス社ですが、開発したのは昭和大学、名古屋大学、サイバーネットシステム社です。

通常の検査では内視鏡をお尻から挿入し、①病変を探し、②病変があれば腫瘍か非腫瘍かを判断し、③腫瘍ならば悪性か良性かを判断し、④悪性癌ならば外科的切除か内視鏡切除かを判断します。後になるほど、医師は高度な判断を求められ、患者の負担は増大します。

そこで、「エンドブレイン」は以下の診断支援をします。

- では、襞の裏の微小ポリープも見逃さず、警告音と画面の点滅でその存在を医師に伝えます。

- では、ポリープの表面を最大520倍で超拡大した画像から、そのポリープが腫瘍性であるか非腫瘍性であるのかを判断します。

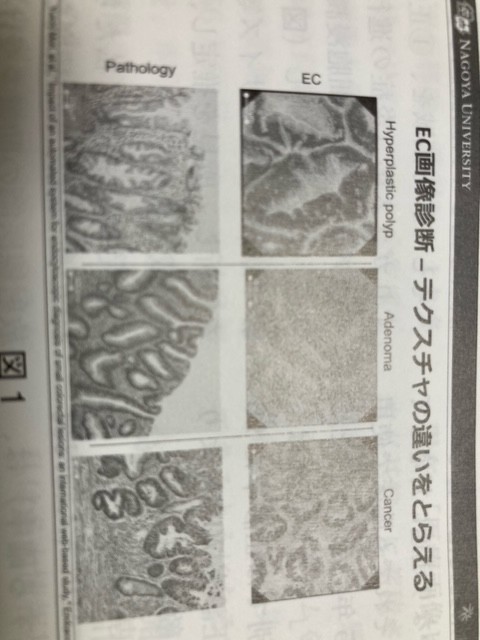

実は、非腫瘍か線種か癌かに寄ってポリープ表面模様が異なります(図1上、下は病理画像)。そこで私たちはテクスチャー解析によって各模様の特徴を利用して指標を作りました。

また、腫瘍か非腫瘍かによって、細胞の核の大きさ、形状、腺腔パターン、血管模様が異なるので、それを利用した指標も作りました。

「エンドブレイン」はこれら計 312の指標に基づいて腫瘍の確立を算出します。

さらに「エンドブレインープラス」を用いればより高度な③④の診断支援が可能です。

これらのAI内視鏡は、診断結果をリアルタイムで示すので、医師はそれをもとに治療方針を決定します。

「エンドブレイン」承認までの道

2013年4月、昭和大学の先生が基礎研究を始め、その後、私たちが合流しました。前臨床試験が始まり、2015年、PMDA(医薬品医療機器総合機構)に薬事戦略相談をしました。

2017年10月、治験がスタートし、2018年6月に終了しました。PMDAに申請前相談の後、製造販売承認申請をすると、半年後の12月、承認されました。

「エンドブレイン」はIT機器です。IT分野は市場の環境変化が著しいので、関係機関にかなり迅速に対応してもらいましたが、それでも臨床で使用可能性なるまで、5年かかりました。

「エンドブレイン」の治験成績は、腫瘍と非腫瘍の識別では正診率は96%で、非専門医(正診率70%)より優秀で、専門医に匹敵しました。

内視鏡医(専門医21人、非専門医9人)によるADR (大腸内視鏡検査で腺種を発見する確率)は、「エンドブレイン」の支援なしで19.9%、支援ありで26.4%でした。

COVID-19のCT画像を診断するAI

私は国立情報学研究所(NII)の医療ビッグデータ研究センターのセンター長を併任しています。2017年、センターは「医療画像ビッグデータクラウド基盤」の運用を開始しました。センターには毎日、「SINET5」(国内外の大学や研究機関を結ぶ学術ネットワーク)による転送やハードディスクの持ち込みにより、さまざまな学術団体から匿名化された医療画像データが大量に送られてきます。センターではこれら医療画像を約3億枚保管し、研究者がクラウド上でデータ解析や深層学習できる環境を整えています。

今回、私たちはこのデータ基盤を利用して、COVID-19のCT画像を診断するAIを開発しました。誤診防止と病院の読影負担の軽減が目的です。

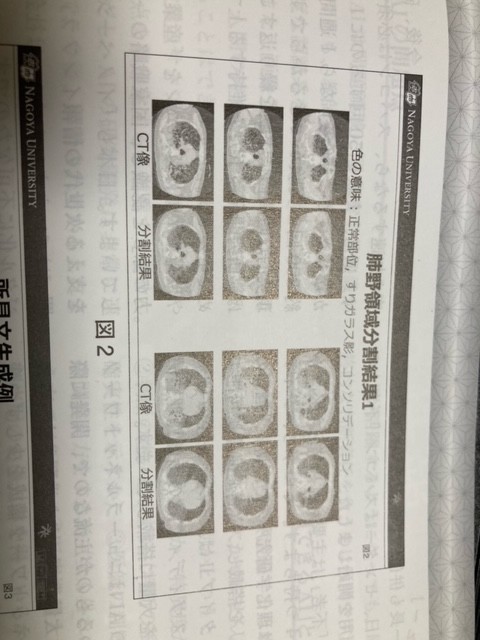

このAIは肺炎の悪化で肺の形状が識別困難になったCT画像でも、肺野領域を正しく自動認識します。

そして肺野領域を、①正常部位、②すりガラス影(炎症の進行)、③コンソリデーション(細胞浸潤が激化した状態)に自動分割し(図2)、肺の陰影の位置・形状・サイズ等から重症度を解析し、所見を推定し、所見文を自動作成します。

開発にあたり、私たちはCOVID-19の典型度分類の精度を高めるため、放射線医師の助言を受けました。

また所見の精度を高めるため、画像を回転・平行移動・変形し、より多くの肺野形状バリエーションを生成し、大量のCT画像を学習させました。

さらに所見文自動作成のため、Googleの自然言語処理モデル「BERT」を拡張し、56万症例の所見文で追加事前学習させ、所見文に特化した単語埋め込みを獲得させました。

図3はAIの生成分と医師の所見文です。生成文の表現は受け取り方を左右するので、注意しています。現在、「医療画像ビッグデータクラウド基盤」に蓄積された胸部CT像を網羅的に解析し、感染状況のサーベイランス・システムを構築しています。今後、全国の感染状況をAIがモニタできるようになるでしょう。

高精度AIの開発には計算インフラが重要

私は名大情報基盤センターのセンター長も併任しています。2020年7月1日、センターはスパコン「不老」の運用を開始しました。「不老」は主要な計算サブシステムを4つ持ちます。そのうち、タイプIは理化学研究所の「富岳」と同型のCPUを搭載し、超高速演算が可能です。タイプIIは、インテル社のCPUとエヌビディア社の画像処理装置GPUを大量に搭載しています。

今のAIはニューラルネットワークを用いるのが主流なので、開発に際しては大量のデータを学習させ、ニューラルネットワーク構成を少しずつ変えて実験を繰り返し、最適の構成を見つける必要があります。その際、大量の計算を行います。

GPUはこの機械学習を高速で行います。ただ、GPU 1台だと20個のニューラルネットワーク構成の中から最適のものを探すのに、20週間かかりますが、1、000台なら0.02週間= 0.1 4日で済みます。これが研究競争力の差に直結します。

「エンドブレイン」の開発では、302万3、005枚の画像を学習するのに約1週間かかりました。今後、研究を加速するなら、スパコンは必須です。通常、実験を50回するのに1年かかりますが、「不老なら」1週間で約800回の実験ができるからです。現実的な時間内に実験を繰り返す事は、研究開発競争力を維持する上で極めて重要です。

欧米や中国はスパコンを「産業競争力の源」と認識し、国家戦略の1部にしています。日本も「イノベーションを支える次世代の情報のインフラ」と位置づけています。スパコンは世界のデジタル化に不可欠なのです。

最近のAIの性能

最近のAIは腹腔鏡で撮影した画像から深度を推定し、腹腔内の形状を3次元復元します。冒頭で紹介した仮想化内視鏡は、大量のCT画像を入力すると、内視鏡画像CG合成し、そのCG画像を写真そっくりに加工します。さらに臓器周辺の細かい血管名も自動認識して表示します。

AIの問題点

AIは問題領域に関する事前知識がなくとも、教師データさえ与えれば、高度な認識系を実現します。

また画像分類や画像生成はできても、人間の持つ専門知識をAIに導入する事はできません。

大量のサンプルやデータから論点や問題点を抽象化することもできません。

ただし、AIの研究開発は非常に早いので、今後、解消されるかもしれません。

未来の医療

将来AIは患者の自宅でウェアラブル・デバイスから送られたデータを解析し、訪問医の超音波画像診断を支援するようになるなるなるでしょう。すでにiPhoneと接続して使用する小型朝音波機器が開発されています。AIは健診を支援し。見逃し防止に力を発揮するでしょう。家庭医や救急医が撮影したX線画像を自動分析し、遠隔地の専門医につなぎ、高度医療の支援もするでしょう。医師が診断や治療方針を決める際、AIが助言し、手術の1部を自立的に手伝うようになるでしょう。

いつの日か、手術の全工程を全自動で行うかもしれません。ただ、技術的にかなり難しく、社会的受容の面でも議論が必要です。

AIが活躍するようになっても最終的な判断責任を負うのは医師です。

医療における「信頼できるAI」とは

医療においてAIが活躍するためには、信頼性の向上が欠かせません。では、その評価基準は何かと言うと、①精度は高いか、(感度か、特異度か)、②判断の迷いを示すか(判断の根拠や確実性を示すか)、③医師の判断に近い間違え方をするか(全く外れた間違え方では困る)、④医療機器として規制当局のお墨付きを得ているか等です。医療分野には、曖昧性がたくさんあります。ポリープの良性と悪性の識別、CT画像における臓器の境界、癌浸潤領域の鑑別、手術での切除部位の境界など、医師やコンピューターでも判断に迷う時があります。その違いを%で提示することが、AIの信頼性の向上につながります。また、AIの性能向上には教師データの増大がカギですが、個人や人種による解剖学的な構造の違いや、食生活や人種よる疾患傾向の違いなど、多様性に配慮することも重要です。

大変なのは稀少疾患(5万人に1人未満)の診断支援をするAIです。日本全体で200例しか集まらないからです。現在、「医療画像ビッグデータクラウド基盤」を活用して多数例の特徴分布を解析し、多数例との距離から稀少例を判定するモデルを開発していますが、今のところ、「判断できない」と正直に言うモデルの開発となっています。将来は稀少例についても、所見分を自動生成するAIにしたいです。

AIと人が共生する未来

メディカルAIの開発は、ビックデータ、スパコン、ネットワークを利用することで加速化しました。すでに画像処理上の問題はかなり解決しています。今後は真に考えることができる高度な判断機能を持つAIの開発が進むでしょう。世界は各社が医療機器へのAI導入を競う「メディカルAIの戦国時代」に突入しています。数年前に創薬で注目されたIBMのAIのワトソンが既に創薬から撤退しているように、メディカルAIの開発は難しい面がありますが、市場は右肩上がりで、今後も成長が予測されています。

「AIをどう開発するか」の段階は過ぎ、「AIをどう使うか」を問う段階に入ったのです。現在のメディカルAIは単機能ですが、将来は多機能になり、多角的に医師を支援し、本物の医師のように診断するようになります。

その時、患者と医師とAIはどう共生すべきでしょうか。社会の仕組みはどうあるべきでしょうか。

これらの問いを専門的見地から総合的にデザインする人材が必要になるので、大学の役割はますます重要になるでしょう。

![]() ←人気ブログランキングに参加しています。ポチっと1票を!

←人気ブログランキングに参加しています。ポチっと1票を!